Здравствуйте, уважаемые читатели блога SdelaemBlog.ru. Сегодня хочу продолжить тему, что делать дальше после создания своего блога или сайта? Конечно уже хочется приступить к работе над блогом: начать писать посты, приглашать читателей на свой сайт, но это все впереди. Для начала нужно подготовить наш сайт к приему не только посетителей, но и поисковых систем или поисковых роботов. Главные поисковые роботы это конечно же Google и Яндекс. А как подготовиться к приему на нашем блоге роботов? Ведь, когда они придут на наш блог, они начнут индексировать не только те страницы, которые нам нужно, но и все остальное, то чему не место в индексе поисковых систем. Поэтому для роботов нужно написать рекомендации, какие страницы мы хотим, добавить в индекс, а какие нет.

Эти рекомендации или правила для роботов будут содержаться в одном текстовом файле, который называется robots.txt. Вот вам и тема сегодняшнего поста.

Итак, начнем с того что создать robots.txt лучше перед тем, как добавлять сайт или блог в поисковые системы, чтобы потом не было никаких ненужных проблем с индексированием вашего сайта.

Создать robots.txt можно, я думаю, не одним способом, но я приведу пример конкретного способа создания правил для поисковых роботов. Не ждите здесь готового файла, потому как robots.txt подбирается для каждого сайта индивидуально и на это требуется время и анализ. Но я расскажу основные моменты на которые стоит обратить внимание при создании данного файла и продемонстрирую примеры для WP и DLE.

Как создать robots.txt для WordPress (WP)

Для создания файла robots.txt для wordpress нужно создать обычный текстовый документ на компьютере. И дать ему имя robots. А txt-это формат документа, но вы ведь знаете об этом. :twisted: Документ готов, что нужно сделать дальше?

Для начала обратимся ко всем роботам или к отдельным роботам, для этого напишем:

User-agent: * (обращение ко всем поисковым роботам)

User-agent: yandex (робот поисковой системы Яндекс)

User-agent: googlebot (робот поисковой системы Google)

После того, как вы написали обращение к определенному роботу (User-agent), нужно прописать сначала то что вы разрешаете индексировать поисковым машинам:

User-agent: *

Allow: /wp-content/uploads/ (нужно для индексирования картинок на сайте или блоге)

Еще можно указать задержку индексирования в самом начале robots.txt. Указывается она в секундах, но я ее не использую, так как не совсем я догнал для чего она конкретно нужна. Когда начал искать в сети, оказалось есть еще куча всяких задержек, поэтому бросил я это, да и не нужно оно мне. Но все же выглядит она так:

Crawl-delay: 4 (или 5, или 2, как хотите)

Также обращения к роботам можно прописать по-другому, обратившись именно к роботам, которые индексируют картинки, например:

User-agent: googlebot-image (поисковый робот - Google, который индексирует картинки)

Allow: /wp-content/uploads/ (разрешение индексировать папку в которой находятся картинки)

Disallow: (нужно прописать, но можно оставить пустым)

User-agent: yandeximages (поисковый робот - Яндекс, который индексирует картинки)

Allow: /wp-content/uploads/ (разрешение индексировать папку в которой находятся картинки)

Disallow: (нужно прописать, но можно оставить пустым)

Затем нужно прописать в файле, куда роботу не следует совать свой нос, делаем это с помощью команды

Disallow: (запретить)

Что запрещать, решать только вам, но я рекомендую пользователям WordPress обязательно запретить индексировать следующее:

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Чтобы в индекс не попадали всякие служебные данные и данные о ваших пользователях.

Также в robots.txt следует указать директиву Host, для избежания проблем с зеркалами. Она указывает на главное зеркало сайта и предназначена для поискового робота — Яндекс. Выглядит она так:

Host: Ваш_сайт.ru

То есть robots.txt для WordPress (WP) с применением минимума функций должен выглядеть примерно так:

User-agent: *

Allow: /wp-content/uploads/

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

User-agent: yandex

Allow: /wp-content/uploads/

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Host: ваш сайт.ru

А также не забудьте указать пути к картам сайта для вашего блога. Если вы еще не сделали карту сайта для своего блога — не беда, скоро рассмотрим эту тему, если вам интересно подписывайтесь:

Sitemap: /sitemap.xml.gz

Sitemap: /sitemap.xml

Вот в принципе и все, файл robots.txt для WordPress (WP) готов, конечно это минимум функций, но должно быть хотя бы это. У меня на блоге robots.txt выглядит пока так:

User-agent: *

Allow: /wp-content/uploads/

Disallow: /cgi-bin

Disallow: /tags/

Disallow: /page/

Disallow: /wp-login

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /*?

Disallow: /search/*/feed

Disallow: /search/*/*

User-agent: yandex

Allow: /wp-content/uploads/

Disallow: /cgi-bin

Disallow: /tags/

Disallow: /page/

Disallow: /wp-admin

Disallow: /wp-login

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /*?

Disallow: /search/*/feed

Disallow: /search/*/*

Host: sdelaemblog.ru

Sitemap: /sitemap.xml.gz

Sitemap: /sitemap.xml

Да, и обратите внимание, что разрывы строчек означают начало нового блока, ну или конец, кому как удобнее. То есть пришел Яндекс, нашел правила для себя (User-agent: yandex) и читает до тех пор пока не появляется разрыв, который сообщает ему о том, что правила для него закончились. Надеюсь, это понятно. И как вы заметили новое правило нужно писать с новой строки.

Как создать robots.txt для DLE (DataLife Engine)

Отличатся от WP пожалуй будет только само построение файла и названия папок и адресов.

Также нужно создать текстовый документ и назвать его robots. И поместить в него примерно следующий код (даю код, так как сам не изучал robots.txt для dle (datalife engine), пока):

User-agent: *

Disallow: /*print

Disallow: /user/

Disallow: /backup/

Disallow: /engine/

Disallow: /language/

Disallow: /templates/

Disallow: /upgrade/

Disallow: /uploads/

Disallow: /autobackup.php

Disallow: /admin.php

Disallow: /index.php?do=addnews

Disallow: /index.php?do=feedback

Disallow: /index.php?do=lostpassword

Disallow: /index.php?do=pm

Disallow: /index.php?do=register

Disallow: /index.php?do=stats

Disallow: /index.php?do=search

Disallow: /index.php?subaction=newposts

Disallow: /?do=lastcomments

Disallow: /statistics.html

Sitemap: http://Ваш_сайт/sitemap.xml

Host: Ваш_сайт

После того как файл с инструкциями для роботов готов нужно залить его на хостинг в корневую папку. Если по адресу http://Ваш_сайт.ru/robots.txt, вы видите свой robots.txt, значит вы все сделали правильно. И поисковые роботы найдут для себя правила и проиндексируют ваш сайт или блог более правильно.

Анализ robots.txt

Как я уже написал, этот файл для каждого индивидуальный и его нужно анализировать для достижения оптимальных результатов. То есть, чтоб нужные страницы были в индексе, а не нужные… ну сами понимаете. И для этого можно воспользоваться сервисом от Google и Яндекс.

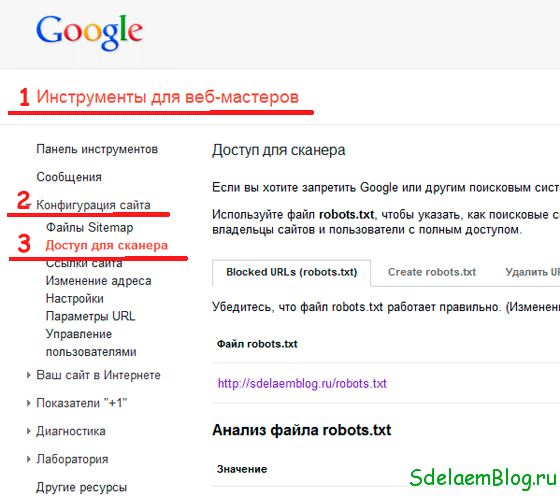

Анализ robots.txt с помощью сервиса Google. Для анализа с помощью Google нужно перейти в инструменты для вебмастера от гугл. Там нужно выбрать ваш сайт или блог(если он не один), анализ которого нужно провести. Затем слева (в панели инструментов) выбираем конфигурация сайта и выбираем доступ для сканера.

Там вы обнаружите свой robots.txt (еще прямо в этом разделе можно создать rotots.txt). Под окошком где будет содержимое вашего файла нужно вписать ссылки, которые вы хотели бы проверить на индексирование:

После нажатия на кнопку Проверить, Google выдаст вам список адресов, которые разрешено индексировать, а какие нет. Вот таким образом можно анализировать robots.txt и если в выдаче вы нашли то чего не должно там быть, нужно запретить индексировать роботу эту страницу или папку в robots.txt и проверить с помощью данного анализа запретилась индексация этой страницы или нет. Если адрес или папка открыты для индексирования проверяем, что сделано не так и т.д.

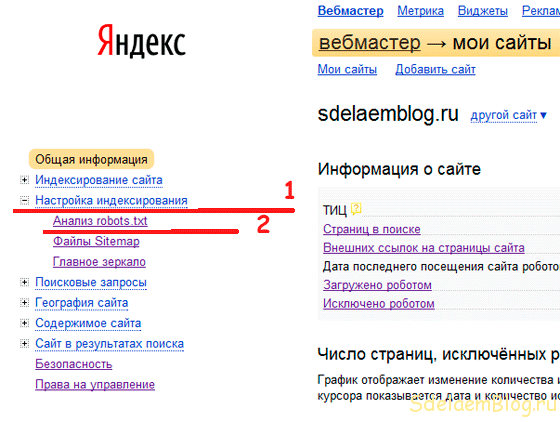

Теперь давайте рассмотрим анализ robots.txt с помощью сервиса от Яндекса. Для анализа с помощью Яндекса нужно перейти в Яндекс.Вебмастер. Там выбираем сайт из списка ваших сайтов. Затем слева в меню выбираем настройка индексирования и анализ robots.txt.

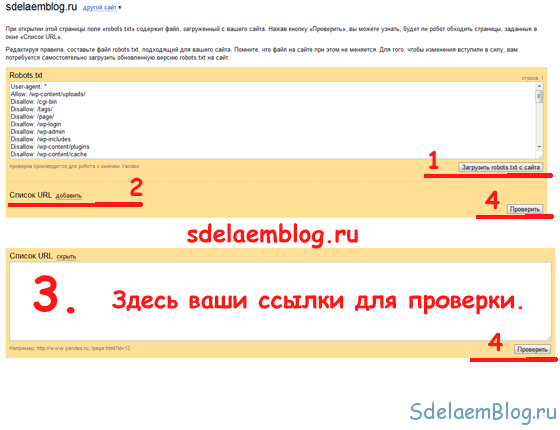

После этого вы попадете на страницу анализа вашего robots.txt. Если ваши правила еще не загружены в окно нажмите загрузить robots.txt с сайта. Затем, внизу, нажмите на кнопку добавить. После нажатия появится второе окно в которое, также как и в Google, нужно вставить или вписать адреса или папки, которые вы хотели бы проверить. И нажимаем на кнопку проверить.

После нажатия на кнопку вы наглядно увидите, какие страницы или папки запрещены к просмотру в robots.txt, а какие нет.

Ну вот пожалуй и все. Спасибо, если вы дочитали этот пост до конца. Надеюсь эта информация будет полезной для вас.

Подписывайтесь на новые статьи моего блога и рекомендуйте их своим друзьям, и Гуглу. Дальше будет больше.

Никита пишет:

И какая может быть проблема от сокращения ? Хотелось бы обоснование Вашего совета.

@ Никита:

Здравствуйте. Обоснуйте, пожалуйста, свою точку зрения.

вот такие строчки Disallow: /*?* стоило бы убрать

@ Евгений:

Можно и упростить — это дело каждого. Статья не дает идеального примера файла robots, а всего лишь говорит о базовых разделах, которые стоит закрыть от индексации.

А разве нельзя упростить в DLE это:

…

Disallow: /index.php?do=search

Disallow: /?do=lastcomments

…

на эту строку: Disallow: /*?*

одна вместо целого списка и дубли убъет как вверху в примере

@ Лена: Поступать в блоггер можно также, если требует того необходимость. Но какие в данной системе разделы существуют не подскажу, так как с блоггером не работаю. Здесь можно узнать подробнее:

https://support.google.com/blogger/answer/2472627?hl=ru

А как в таком случае поступать с Blogspot?

«Еще можно указать задержку индексирования в самом начале robots.txt. Указывается она в секундах, но я ее не использую, так как не совсем я догнал для чего она конкретно нужна.» — Задержка нужна чтобы сайт не помер от нагрузки, создаваемой поисковым ботом, когда он шерстит сайт. В частности, это относиться к дешёвым хостинговым тарифам, где не допускается высокая нагрузка на хостинг. Если создаваемая ботом нагрузка превышает определённый барьер нагрузки для текущего тарифа, то хостер может временно блокировать сайт, пока нагрузка не придёт в норму.

Спасибо за дополнение.